Prompt Engineering Masterguide: So erstellen Sie perfekte Prompts von Grund auf

In diesem umfassenden Masterguide lernen Sie, wie Sie vom Grundverständnis bis zur Meisterschaft Ihre Prompting-Fähigkeiten entwickeln können. Wir untersuchen, wie Prompting als kognitives Werkzeug funktioniert, wie iterative Verbesserungen zu optimalen Ergebnissen führen und welche systematischen Ansätze die Profis verwenden.

Inhaltsverzeichnis:

- Prompting als Denkwerkzeug

- Iteratives Prompting: Lernen durch Feedback

- Computational Thinking im Prompting

- Kreativität durch gezielte Steuerung

- Systematik durch Prompt-Design-Patterns

- Fazit

- Referenzen

Wussten Sie, dass 80% der Nutzer von generativen KI-Systemen mit den ersten Ergebnissen ihrer Prompt Engineering-Versuche unzufrieden sind?

Tatsächlich ist die Kunst des perfekten Prompts eine Fähigkeit, die systematisch erlernt werden kann. Die Kommunikation mit Large Language Models (LLMs) erfordert mehr als nur einfache Anfragen – sie verlangt ein tiefes Verständnis dafür, wie diese AI-Systeme Informationen verarbeiten und interpretieren.

Effektives Prompt Engineering hilft nicht nur, bessere Antworten zu erhalten, sondern reduziert auch Probleme wie Bias und Halluzinationen, die häufig bei generativen KI-Systemen auftreten. Darüber hinaus fördert es Kreativität, indem es die KI dazu bringt, neuartige und nützliche Lösungsansätze zu generieren. Beginnen wir mit den Grundlagen des effektiven Prompt Engineerings.

Prompting als Denkwerkzeug

Prompts zu erstellen erfordert mehr als nur eine Frage zu formulieren – es ist ein tiefgreifender kognitiver Prozess, der unser Denken widerspiegelt und gleichzeitig formt. Bei der Interaktion mit generativen KI-Systemen nutzen wir Prompts nicht nur als Anweisungen, sondern als Erweiterungen unserer Denkprozesse.

Was ein Prompt über unser Denken verrät

Die Art und Weise, wie wir Prompts formulieren, offenbart unsere Denkmuster und Problemlösungsansätze. Tatsächlich ist das Erstellen eines Prompts ein enthüllender Akt – es zwingt uns, Gedanken zu strukturieren und Intentionen zu klären. Studien zeigen, dass der Prozess der Prompt-Erstellung selbst bereits kognitive Klarheit schafft, noch bevor die KI antwortet.

Beim Verfassen eines Prompts müssen wir definieren, was wir wissen wollen, und dabei implizit unsere eigenen Annahmen, Wissenslücken und Ziele offenlegen. Die Formulierung eines effektiven Prompts verlangt von uns, zu überlegen: "Wie will ich, dass die KI mir hilft? Welche Interaktion suche ich? Was versuche ich zu erreichen?" Diese Fragen zwingen uns, unser eigenes Verständnis zu vertiefen.

Der Akt des Prompt-Schreibens ist daher oft aufschlussreicher als die erhaltene Antwort. Er hilft uns, Probleme aufzuschlüsseln, Kontext zu definieren und unsere Absichten zu präzisieren – alles wichtige Schritte für fundiertes Denken.

Prompting als kognitive Entlastung

Menschen haben seit jeher externe Werkzeuge genutzt, um Denkprozesse auszulagern – von Notizbüchern bis hin zu digitalen Kalendern. Dieses Phänomen wird als "kognitive Entlastung" (cognitive offloading) bezeichnet. Allerdings unterscheidet sich die durch generative KI ermöglichte Entlastung grundlegend von früheren Hilfsmitteln.

Während traditionelle Werkzeuge lediglich Informationen speichern oder abrufen, können moderne AI-Systeme Inhalte synthetisieren, argumentieren und bewerten. Dies führt zu einer qualitativ anderen Form der kognitiven Entlastung – Aufgaben, die einst tiefgreifendes Nachdenken erforderten, können nun mit minimalem geistigem Aufwand erledigt werden.

Allerdings zeigen Studien, dass Fachleute, die generative KI-Tools nutzen, zwar weniger kognitive Anstrengung berichten, aber gleichzeitig ein erhöhtes Vertrauen in die Qualität ihrer Ergebnisse entwickeln [1]. Diese Diskrepanz zwischen wahrgenommener und tatsächlicher Beteiligung birgt Risiken. Es entsteht ein Spannungsfeld: KI-Tools sollen uns unterstützen, fördern jedoch oft Verhaltensweisen, die zu verminderter geistiger Anstrengung, geringerem kritischen Engagement und eingeschränktem Lernen führen.

Dennoch ist kognitive Entlastung nicht zwangsläufig negativ. Der strategische Einsatz von Prompting kann unsere kognitiven Ressourcen für andere Aktivitäten freisetzen und unsere Fähigkeiten erweitern, anstatt sie zu ersetzen.

Metakognition durch gezielte Fragestellung

Strukturiertes Prompting kann als metakognitives Gerüst dienen, das selbstreguliertes Lernen fördert [1]. Durch gezielte Fragen werden wir angeregt, innezuhalten, zu reflektieren und unsere Annahmen zu überprüfen. Dieser Prozess unterstützt die Metakognition – das Bewusstsein für und die Kontrolle über unsere eigenen Lernprozesse.

Forschungen belegen, dass der explizite Unterricht von metakognitiven Strategien die Lernleistung erheblich verbessern kann (+8 Monate zusätzlicher Fortschritt) [2]. Auf Prompting übertragen bedeutet dies: Indem wir lernen, bessere Fragen zu stellen, verbessern wir nicht nur die KI-Antworten, sondern auch unser eigenes Denken.

Effektive metakognitive Prompting-Strategien umfassen:

- Planung und Aktivierung: Fragen stellen, die Vorwissen aktivieren und Ziele setzen

- Überwachung und Bewertung: Die KI nutzen, um Annahmen zu hinterfragen und blinde Flecken aufzudecken

- Reflexion und Anpassung: Systematisch aus KI-Antworten lernen und Denkmuster verbessern

Die Entwicklung metakognitiver Fähigkeiten durch Prompting führt zu größerer geistiger Unabhängigkeit und fördert kritisches Denken – genau jene Fähigkeiten, die für die effektive Nutzung generativer KI entscheidend sind.

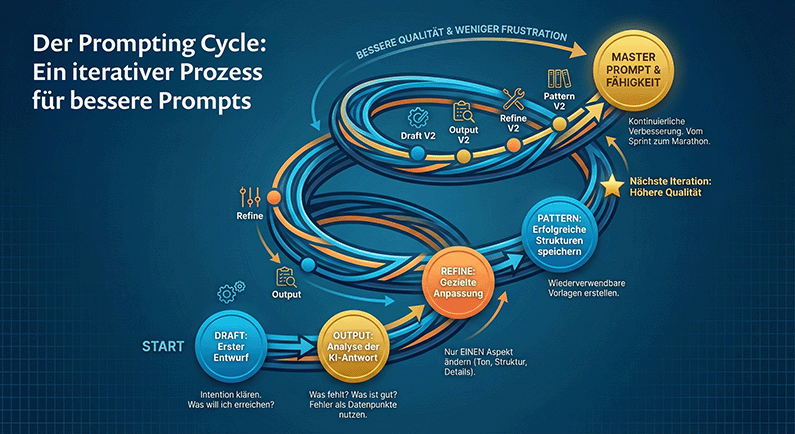

Iteratives Prompting: Lernen durch Feedback

Der Prozess des Prompt Engineerings gleicht selten einem Sprint – vielmehr ist es ein Marathon mit mehreren Etappen. Studien zeigen, dass selbst erfahrene Anwender nur selten beim ersten Versuch optimale Ergebnisse erzielen [3]. Die Kunst des perfekten Prompts liegt nicht in der initialen Formulierung, sondern im systematischen Verbessern durch Feedback.

Warum ein Prompt selten beim ersten Mal perfekt ist

Selbst präzise formulierte Prompts führen häufig nicht sofort zum gewünschten Ergebnis. Dies hat mehrere Gründe: Einerseits interpretieren LLMs Anfragen manchmal anders als beabsichtigt, andererseits ist unsere eigene Vorstellung vom Ergebnis oft unvollständig. Forschungsergebnisse belegen, dass einzelne Prompts über mehrere Lernsitzungen hinweg selten die ideale Wirkung erzielen [3].

Ein weiteres Problem liegt in der metakognitiven Überwachung – Nutzer überschätzen häufig ihre Lernfortschritte und beenden ihre Bemühungen, bevor sie die Aufgabe tatsächlich gemeistert haben [3]. Diese ungenaue Selbsteinschätzung führt zu fehlerhaftem internem Feedback und somit zu suboptimalen Ergebnissen.

Darüber hinaus kann das komplexe Zusammenspiel zwischen Anweisung, Kontext und Ausdrucksweise dazu führen, dass selbst kleine Änderungen in der Reihenfolge der Inhalte die Antworten erheblich beeinflussen [4]. Daher ist ein iterativer Ansatz nicht optional, sondern zwingend erforderlich.

Wie man aus schlechten Antworten bessere Prompts macht

Die Qualität eines Prompts verbessert sich durch systematische Iteration. Anstatt unbefriedigende Ergebnisse als Fehler zu betrachten, sollten sie als Datenpunkte für die Verbesserung genutzt werden [5]. Folgende Strategie hat sich bewährt:

- Analyse der erhaltenen Antwort – Identifizieren Sie, was funktioniert hat und was nicht

- Gezielte Anpassungen – Ändern Sie jeweils nur einen Aspekt (Tonfall, Detailtiefe, Format oder Struktur) [6]

- Folgeprompts nutzen – Bauen Sie auf dem Erhaltenen auf, statt neu zu beginnen

- Erfolgreiche Muster bewahren – Speichern Sie funktionierende Prompt-Strukturen als Vorlagen [6]

Weiterhin zeigt die Forschung, dass detailliertes Feedback die wirksamste Komponente zur Verbesserung ist, zumindest in computergestützten Umgebungen [3]. Dieses Feedback dient als Medium, durch das Lernende die von ihnen eingesetzten kognitiven Strategien und deren Wirksamkeit erkennen können [3].

Bei der Verfeinerung von Prompts ist es entscheidend, nicht zu viele Elemente gleichzeitig zu ändern – dies erschwert die Identifikation wirksamer Verbesserungen [5]. Stattdessen empfiehlt sich eine schrittweise Anpassung mit klarem Fokus auf einzelne Verbesserungsbereiche.

Beispiele für effektive Prompt-Iterationen

Ein anschauliches Beispiel für erfolgreiche Prompt-Iteration stammt aus dem Bereich der Werbetexterstellung:

- Iteration 1: "Schreib einen Werbetext." Ergebnis: Zu allgemeiner, unspezifischer Text ohne klare Struktur.

- Iteration 2: "Schreib einen Werbetext für ein Fitnessprodukt mit Überschrift und Hauptteil." Ergebnis: Bessere Struktur, aber immer noch zu generisch.

- Iteration 3: "Schreib einen überzeugenden Werbetext für ein Laufband mit klarer Überschrift und informativem Hauptteil, der sich an Heimsportler richtet." Ergebnis: Deutlich zielgerichteterer Text mit passender Struktur [4].

Eine systematische Studie zur Prompt-Optimierung ergab, dass die Spezifizität des Fachgebiets – also die korrekte Verwendung technischer Begriffe – der wichtigste Faktor für die Erzeugung von Feedback auf Expertenniveau ist [7]. Bei einer Finanzdienstleistungsklassifizierung konnte die Genauigkeit durch iterative Verfeinerung von anfänglich 60% auf beeindruckende 100% in nur fünf Iterationsschritten gesteigert werden [8].

Zusammenfassend lässt sich sagen: Prompt Engineering ist kein einmaliger Akt, sondern ein kontinuierlicher Verbesserungsprozess. Betrachten Sie jede Antwort als Gelegenheit zum Lernen, verfeinern Sie systematisch Ihre Anfragen und behalten Sie erfolgreiche Muster bei. Durch diesen iterativen Ansatz werden Ihre Prompts zunehmend präziser und leistungsfähiger.

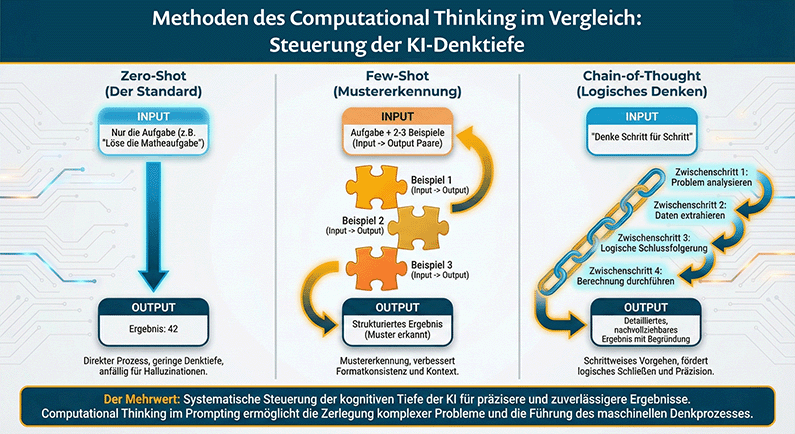

Computational Thinking im Prompting

Computational Thinking bildet das Fundament für effektives Prompt Engineering. Diese kognitiven Fähigkeiten – ursprünglich aus der Informatik stammend – ermöglichen es uns, komplexe Probleme systematisch zu lösen und dabei mit künstlicher Intelligenz besser zu kommunizieren.

Problemzerlegung in Sub-Prompts

Komplexe Aufgaben mit generativer KI lassen sich durch Zerlegung in kleinere, überschaubare Teilprobleme effizienter lösen. Diese Strategie, bekannt als "Decomposed Prompting" (DECOMP), verbessert die KI-Leistung ohne den Einsatz größerer Modelle zu erfordern. Bei diesem Ansatz wird jeder Sub-Prompt für einen spezifischen Aspekt des Gesamtproblems konzipiert.

Anstatt beispielsweise eine komplizierte Textanalyse in einem einzigen Prompt zu verlangen, können Sie zunächst nach einer Zusammenfassung fragen, dann nach spezifischen Themen und schließlich nach Verbindungen zwischen diesen. Diese Methode entspricht der menschlichen Problemlösungsstrategie und führt zu präziseren Ergebnissen. Forschungen zeigen, dass dieser strukturierte Ansatz besonders bei mathematischen Problemen, komplexen Sequenzen und umfangreichen Aufgaben effektiv ist.

Mustererkennung durch Few-Shot-Beispiele

Few-Shot Prompting nutzt die Fähigkeit von LLMs, aus wenigen Beispielen zu lernen, ohne zusätzliches Training. Diese Technik, auch "In-Context Learning" (ICL) genannt, leitet das Modell an, indem es Muster aus gezeigten Beispielen erkennt und auf neue, ähnliche Eingaben anwendet.

Die Strategie umfasst:

- Zero-Shot: Keine Beispiele, nur Anweisungen

- One-Shot: Ein einzelnes Beispiel zur Aufgabenerklärung

- Few-Shot: Zwei oder mehr Beispiele zur Mustererkennung

Few-Shot Prompting ist besonders wertvoll, wenn Ausgaben in einem spezifischen Format strukturiert sein müssen, das schwer zu beschreiben ist. Studien belegen, dass diese Methode die Zuverlässigkeit von LLMs bei Aufgaben erhöht, die bestimmte Formate oder Muster erfordern, wie strukturierte Informationsextraktion oder Inhaltsgeneration.

Abstraktion durch wiederverwendbare Templates

Wiederverwendbare Prompt-Templates erhöhen die Effizienz durch modulare, flexible Strukturen. Diese Templates enthalten Platzhalter (wie {{produkt_name}} oder {{zielgruppe}}), die bei Bedarf mit neuen Werten ausgetauscht werden können.

Der modulare Aufbau trennt Constraints, Ziele und aufgabenspezifische Anweisungen in einzelne Komponenten. Dadurch können Templates über verschiedene Projekte, Personen oder Plattformen hinweg wiederverwendet werden, was Zeit spart und konsistente Ergebnisse sichert. Besonders nützlich sind sie für repetitive Aufgaben wie Produktbeschreibungen, Berichterstellung oder Codeanalyse.

Algorithmisches Denken mit Chain-of-Thought

Chain-of-Thought (CoT) Prompting fördert schrittweises Denken bei komplexen Aufgaben. Diese Technik leitet LLMs an, ein Problem in logische Zwischenschritte zu zerlegen, ähnlich wie Menschen komplexe Probleme angehen würden.

Statt direkt zu einer Antwort zu springen, wird das Modell durch einen kohärenten Gedankengang geführt. Dadurch verbessert sich die Leistung bei Aufgaben, die mehrschrittiges Denken erfordern, wie mathematische Probleme oder logische Deduktion. Forschungsergebnisse zeigen, dass CoT die Genauigkeit und Zuverlässigkeit von KI-Antworten erhöht, besonders bei Aufgaben, die mehrstufiges Schlussfolgern erfordern.

Zusätzlich haben sich Varianten wie Zero-Shot CoT, Automatic CoT und Multimodal CoT entwickelt, die den Ansatz weiter verfeinern und auf unterschiedliche Anwendungsfälle anpassen.

Die Anwendung von Computational Thinking im Prompt Engineering transformiert die Art und Weise, wie wir mit generativer KI interagieren – von reaktiven Anfragen hin zu durchdachten, strukturierten Konversationen.

Kreativität durch gezielte Steuerung

Kreative Prompt-Techniken erschließen das volle Potenzial von Large Language Models. Im Gegensatz zu einfachen Anfragen nutzen kreative Prompts die generative Kraft von KI-Systemen nicht nur als Wissensquellen, sondern als Partner im Ideenfindungsprozess.

Divergente Ideen mit Stilwechsel erzeugen

Divergentes Denken bildet die Grundlage kreativer Prompt-Strategien. Diese Denkweise erzeugt durch freies, unstrukturiertes Brainstorming neue Ideen, anstatt den direktesten Weg zu einer einzelnen Antwort zu suchen. Forschungsergebnisse belegen, dass divergentes Denken am effektivsten ist, wenn die Beteiligten sich sicher fühlen, Zeit und Raum zur Inspiration haben und mit anderen zusammenarbeiten [9].

Für optimale Ergebnisse sollten Sie divergentes Denken früh in den erweiterungsfähigen Phasen der Ideenfindung einsetzen. Dabei ist es wichtig:

- Das Problem neu zu formulieren

- Einschränkungen zu verstehen und zu hinterfragen

- Neue Lösungsstrategien zu finden

- Die scheinbaren Grenzen Ihres Designraums zu erkennen und zu überwinden [10]

Durch gezielte Stilwechsel in Ihren Prompts – etwa durch Änderung des Tons, der Perspektive oder des Formats – schaffen Sie Raum für unerwartete Verbindungen und innovative Lösungen.

Konvergente Auswahl durch Bewertung und Filter

Nach der Generierung vielfältiger Ideen folgt die Phase der konvergenten Auswahl. Hierbei helfen Bewertungs- und Filterprompts, die qualitativ hochwertigsten Ergebnisse zu identifizieren. Konvergentes Denken tritt gegen Ende von Ideationssitzungen auf und schließt diese ab, indem Teams Ideen sichten, nach Themen gruppieren und letztendlich über Gewinner und Verlierer entscheiden [11].

Verbalized Sampling (VS) ist eine fortschrittliche Technik, die KI anweist, mehrere Antworten basierend auf der internen Wahrscheinlichkeitsverteilung zu generieren. Dadurch erhalten Sie verschiedene mögliche Lösungen mit ihren zugehörigen Wahrscheinlichkeiten und können die beste Option auswählen [12].

Techniken: Provokation, Einschränkung, Metapher

Drei besonders wirksame Methoden zur kreativen Steuerung von Prompts sind:

- Provokationen: Erstellen Sie bewusst falsche Aussagen über einen Aspekt des Problems, um Normen zu hinterfragen. Diese Technik nutzt Widerspruch, Verzerrung oder Umkehrung von Annahmen [13].

- Einschränkungen: Paradoxerweise fördert die Begrenzung von Vokabular, Stil oder Format oft Kreativität. Studien zeigen, dass kontinuierliches Wechseln zwischen Aufgaben die kreative Leistung verbessern kann, indem kognitive Fixierungen reduziert werden [14].

- Metaphern und Analogien: Diese helfen, abstrakte oder komplexe Phänomene durch Bezug auf Bekanntes zu erklären. Beispielsweise kann die Beschreibung von Fehlinformationen als "biologische Ansteckung" abstraktes Denken auf kreative Weise strukturieren [13].

Effektives kreatives Prompting erfordert eine ausgewogene Balance: Zu offene Anfragen führen zu chaotischen Antworten, zu starre Vorgaben ersticken die Ideenfindung. Deshalb sollten Sie bei komplexen Aufgaben mit generativer KI eine Mischung aus gezielter Steuerung und kreativer Freiheit anstreben [13].

Systematik durch Prompt-Design-Patterns

Prompt-Design-Patterns stellen wiederverwendbare Lösungsansätze für wiederkehrende Probleme im Prompt Engineering dar, ähnlich wie Entwurfsmuster in der Softwareentwicklung. Diese strukturierten Muster helfen dabei, konsistente, effektive und zuverlässige Interaktionen mit LLMs zu gestalten.

Role Prompting und Step-by-Step

Role Prompting weist dem LLM eine spezifische Rolle oder Persona zu, wodurch die Antworten auf bestimmte Weise gelenkt werden. Die grundlegende Struktur folgt dem Muster: "Agiere als [Persona X] und führe Aufgabe [Y] aus." Diese Technik verbessert nachweislich die Genauigkeit bei bestimmten Aufgabentypen, besonders bei Wissens- und Schlussfolgerungsaufgaben.

Bei der Anwendung von Role Prompting empfiehlt es sich:

- Geschlechtsneutrale Begriffe zu verwenden

- Nicht-intime zwischenmenschliche Rollen zu nutzen

- Direkte Rollenangaben statt imaginativer Konstrukte zu wählen

Der Step-by-Step Ansatz hingegen zerlegt komplexe Aufgaben in sequentielle Teilschritte und führt das Modell durch einen strukturierten Lösungsweg. Dadurch werden Genauigkeit und Nachvollziehbarkeit der Ergebnisse erheblich verbessert.

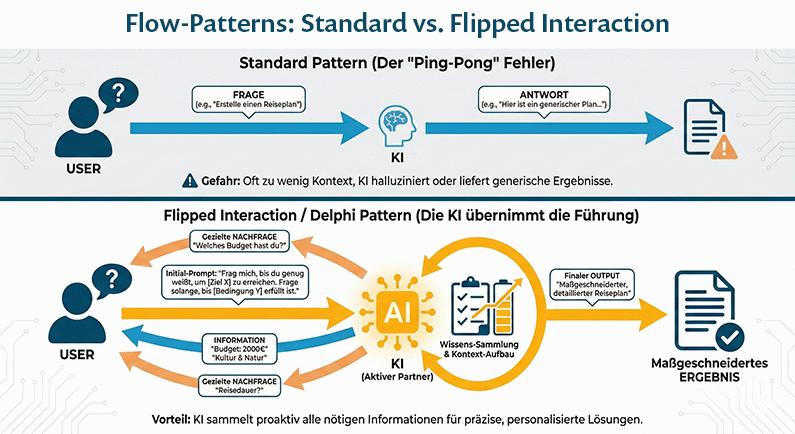

Delphi- und Flipped-Interaction-Pattern

Das Flipped-Interaction-Pattern kehrt die übliche Dialogrichtung um: Statt dass der Nutzer Fragen stellt, übernimmt das LLM die führende Rolle und sammelt durch gezielte Nachfragen die nötigen Informationen. Die Grundstruktur lautet: "Ich möchte, dass du mir Fragen stellst, um [Ziel X] zu erreichen. Du solltest solange fragen, bis [Bedingung Y] erfüllt ist."

Dieses Muster ist besonders effektiv für maßgeschneiderte Ergebnisse wie personalisierte Reisepläne oder Fitnessroutinen. Es verwandelt das LLM vom passiven Antwortgeber zum aktiven Gesprächspartner.

Wie man eigene Prompt-Bibliotheken aufbaut

Eine persönliche Prompt-Bibliothek steigert die Effizienz und Konsistenz Ihrer KI-Interaktionen erheblich. Beginnen Sie mit der Identifizierung Ihrer häufigsten KI-Aufgaben und extrahieren Sie erfolgreiche Prompts aus Ihrer Chat-Historie.

Für eine praktische Bibliothek benötigen Sie:

- Ein zentrales, einfaches Speichersystem (Google Doc, Notion, Evernote)

- Klare Bezeichnungen und Kategorien für schnelles Auffinden

- Dokumentation von Anwendungsfällen und Variablen

- Kontinuierliche Verbesserung basierend auf Nutzungserfahrungen

Besonders wertvoll ist ein "Voice Prompt", der Ihren persönlichen Kommunikationsstil definiert und in anderen Prompts referenziert werden kann. Dadurch wirken alle KI-Antworten persönlicher und konsistenter.

Fazit

Effektives Prompt Engineering stellt zweifellos eine erlernbare Fertigkeit dar, die sowohl systematisches Denken als auch kreative Flexibilität erfordert. Während des gesamten Lernprozesses werden Sie feststellen, dass Ihre Prompts nicht nur bessere Antworten erzeugen, sondern auch Ihr eigenes Denken schärfen. Die Zerlegung komplexer Probleme, das Erkennen von Mustern und die schrittweise Verfeinerung Ihrer Anfragen bilden dabei das Fundament Ihrer Prompt-Kompetenz.

Tatsächlich funktioniert der iterative Ansatz am besten. Betrachten Sie jeden Prompt als Experiment, jede Antwort als Datenpunkt für Verbesserungen. Nach und nach entwickeln Sie ein Gespür dafür, welche Formulierungen, Strukturen und Techniken für bestimmte Aufgabentypen am effektivsten sind.

Darüber hinaus sollten Sie Ihre erfolgreichen Prompts sammeln und kategorisieren. Diese persönliche Prompt-Bibliothek wird mit der Zeit zu einem wertvollen Werkzeug, das Ihre Produktivität erheblich steigert. Besonders wirkungsvoll erweist sich die Kombination verschiedener Techniken – etwa Role Prompting mit Chain-of-Thought oder Decomposed Prompting mit Few-Shot-Beispielen.

Außerdem lohnt es sich, zwischen divergentem und konvergentem Denken zu wechseln. Zunächst breite Ideenfindung fördern, anschließend die besten Optionen gezielt auswählen. Diese Balance zwischen Kreativität und Struktur charakterisiert fortgeschrittenes Prompt Engineering.

Denken Sie stets daran, dass die Kommunikation mit KI-Systemen letztendlich ein Dialog zwischen menschlicher Absicht und maschineller Interpretation bleibt. Je besser Sie die Funktionsweise von LLMs verstehen, desto präziser können Sie Ihre Anfragen gestalten.

Prompt Engineering entwickelt sich stetig weiter, parallel zur Entwicklung der KI-Systeme selbst. Die in diesem Masterguide vorgestellten Grundprinzipien – klares Denken, systematische Iteration, computationelle Strukturierung, kreative Steuerung und musterbasierende Systematik – bleiben jedoch zeitlos relevant.

Beginnen Sie also mit einfachen Prompts, analysieren Sie die Ergebnisse sorgfältig und verfeinern Sie Ihre Anfragen Schritt für Schritt. Durch konsequente Anwendung der vorgestellten Techniken werden Sie bald die Fähigkeit entwickeln, mit wenigen gezielten Worten genau die Antworten zu erhalten, die Sie benötigen – eine unverzichtbare Kompetenz im Zeitalter der generativen künstlichen Intelligenz.

Referenzen

[1] - https://www.mdpi.com/2306-5729/10/11/172 [2] - https://educationendowmentfoundation.org.uk/education-evidence/teaching-learning-toolkit/metacognition-and-self-regulation [3] - https://pmc.ncbi.nlm.nih.gov/articles/PMC10381603/ [4] - https://cloud.google.com/vertex-ai/generative-ai/docs/learn/prompts/prompt-iteration [5] - https://codesignal.com/blog/strategies-used-in-prompt-engineering/ [6] - https://kanerika.com/blogs/ai-prompt-engineering-best-practices/ [7] - https://www.researchgate.net/publication/388440873_AI_Feedback_in_Education_The_Impact_of_Prompt_Design_and_Human_Expertise_on_LLM_Performance [8] - https://github.com/aws-samples/sample-prompt-optimization-with-reasoning-feedback [9] - https://www.atlassian.com/blog/productivity/divergent-thinking-exercises [10] - https://www.interaction-design.org/literature/topics/lateral-thinking?srsltid=AfmBOor2VNn2GXfE0_kIFl4mr6RhZmrQlucBaQCSz6Bg2uu7WSeD_ad2 [11] - https://www.interaction-design.org/literature/article/how-to-think-and-work-divergently-4-ideation-methods?srsltid=AfmBOoqRHkDPXGd8pO3b6D2RN8Cv8ETAiBoe2EVGSA3p5YLCXHPR4rhh [12] - https://www.forbes.com/sites/lanceeliot/2025/11/01/prompt-engineering-newest-technique-is-verbalized-sampling-that-stirs-ai-to-be-free-thinking-and-improve-your-responses/ [13] - https://link.springer.com/chapter/10.1007/978-3-032-03593-6_12 [14] - https://www.sciencedirect.com/science/article/abs/pii/S074959781630108X